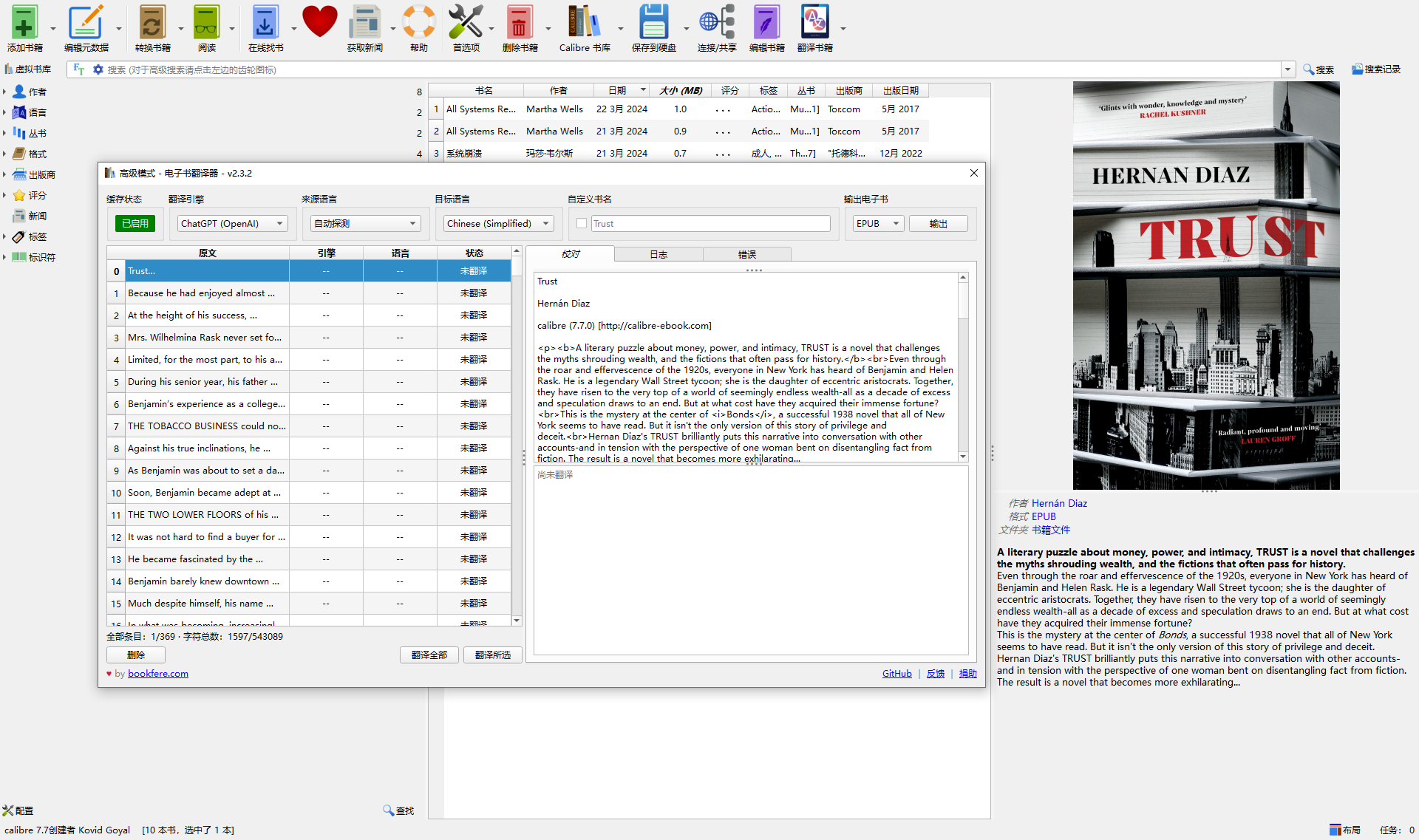

chat CPT刚出来的时候,人们就发现大语言模型的翻译能力非常的强悍,甚至还可以给翻译的文字进行润色,比普通的机器翻译更加易懂,而今在互联网的时代,几乎所有的知识都能够在网上找到。就拿读书这件事来说,纸质书已经不是我的第一选择了,电子书才是。一来它可以它不占体积,装在手机上,或者想要更好的体验放在平板上就可以了,不占任何的空间。第二,现在人工智能语音的技术已经非常的流畅,自然呢!还可以一边散步或者一边锻炼,一边让人工智能文本转语音软件,将书的内容读给你听,放松眼睛和利用空闲时光,而喜欢读电子书的人,肯定都知道,世界上最大的电子书下载网站z library。好吧,根据我的经验,想要读的书,百分之九十,这上面都能够找到电子版哦。特别是英文原版畅销书时效性更强。 之前发帖说过。在一个外文网站上看过一本比较新的畅销书,书名叫《trust》——《信任》,讲的是一位华尔街金融富豪的成长和婚姻经历的书。而这本书实际上是由四本小书共同组成的。每一本书都是讲述了同一个故事,但是是从不同的立场和不同的角度来讲的,却让人得出为故事人物完全不同的观感,完全不同的感受,而这本书是没有中文译本的。如果直接看英文,虽然也能看,但是毕竟不是英文母语,水平还是有限会看得非常吃力,很大可能是没办法坚持看完的。 当时是借用了一个非常好用的,叫做沉浸式翻译的浏览器插件。这个插件可以调用网上的各种翻译引擎。比如谷谷歌和微软,还有国内的有道、腾讯翻译服务。在很短的时间内将这本书翻译成中文。因为这样的翻译引擎是逐句逐段的翻译,没有上下文,所以读起来还是有些不太好懂,但是却比直接看原文要轻松的多。 当然随着facebook也就是现在的meta开源了llama模型之后,很多开源的模型如雨后春笋般报了出来。而且在这些模型当中,小参数的比如7b、13b在经过量化压缩之后,可以在本地的PC机上运行,其中顶尖的开源模型效果已经不输open ai的上一代产品chat GPT3.5了。 这两天就发现一个非常好的办法,可以在本地PC上利用开源模型翻译外文电子书,而且翻译效果明显强于在线的专用翻译引擎。这个方法要使用几个软件,一个是calibre——一个开源的PC端电子书管理软件,下载安装之后,点击首选项。在插件栏中安排一个e book translator的插件。另一个就是我通常用来在本地运行大语言AI模型的神器LM studio,你不需要任何的编程和代码经验,只需要从huggin face抱抱脸网站上把对应的模型下载下来,放在一个文件夹里,然后在软件里面配置一下,指向这个文件夹,就能够运行本地的chatGPT了。同时它还有一个非常好的功能,就是提供了一个和open AI兼容的api。可以让其他的应用程序来调用访问大语言模型的能力。 有了这两个软件之后,就可以自行翻译电子书了。首先把你想翻译的电子书导入calibre中的,然后配置一下calibre的e book translator插件的参数,选择open AI的API,然后将网址改成localhost,也就是本地主机。然后就是用LM studio本地运行大模型,虽然这是可以用的,但是大多数人的PC机性能还是有限。所以API的响应速度只能说是差强人意。所以需要把延时和等待时间这两个参数设置的长一点,这样就会减少翻译过程中的出错率。这个参数可能要试验几次。根据每个人的电脑性能高低来确定。 最终确定配置好了之后,在Calibre中选择要翻译的电子书,然后点击翻译按钮,就会弹出一个窗口,里面将电子书分成了若干段,一段一段的丢给LM studio来进行翻译。这里有一条,现在的开源大元模型多如牛毛。如果要翻译成中文的话,肯定要选择国内的开源模型。我的使用感受最好的中文大语言模型应该是阿里的通义千问,还有deep seek以及及李开复旗下的o1AI开发的Yi模型。而就翻译来说,我觉得效果最好的就是阿里的通义千问。有时候我在网上浏览到看不懂的英语长难句,丢给这三个模型,让他们做语法分析,同意千万给出的答案是最准确的。为了验证,我将刚才提到那本《trust.》喂给了这套系统,让他翻译一遍,翻译出来的结果与谷歌翻译出来的在可读性上和文字的流畅程度上明显上来一个很大的台阶。当然,这种翻译翻译办法的一大缺点就是速度很慢。可能是我的电脑性能有限。翻译一本书大概需要一整晚上,而用谷歌的翻译引擎。翻译一本书可能只要几分钟,总之这套办法还是非常好用的,而且几乎不需要什么成本,真的是科技改变生活嗯。

| author | cheva |

|---|---|

| permlink | 7b4aecf1cb6a3 |

| category | hive-105017 |

| json_metadata | {"image":["https://cdn.steemitimages.com/DQmS6yjYvUmvDhbPGGu4a7nRouvsT2PY24cpyfbzaEkjSw8/image.png"],"tags":["hive-105017","cn","cn-reader","palnet","neoxian","life","lifestyle"],"description":"chat","app":"ecency/3.1.1-vision","format":"markdown+html","image_ratios":["1.6887"]} |

| created | 2024-03-22 07:56:36 |

| last_update | 2024-03-22 07:56:36 |

| depth | 0 |

| children | 0 |

| last_payout | 2024-03-29 07:56:36 |

| cashout_time | 1969-12-31 23:59:59 |

| total_payout_value | 1.562 HBD |

| curator_payout_value | 1.548 HBD |

| pending_payout_value | 0.000 HBD |

| promoted | 0.000 HBD |

| body_length | 1,976 |

| author_reputation | 301,817,720,448,527 |

| root_title | 从谷歌到开源:提升电子书翻译体验的新方法 |

| beneficiaries | [] |

| max_accepted_payout | 1,000,000.000 HBD |

| percent_hbd | 10,000 |

| post_id | 132,242,447 |

| net_rshares | 5,741,616,571,997 |

| author_curate_reward | "" |

| voter | weight | wgt% | rshares | pct | time |

|---|---|---|---|---|---|

| rivalhw | 0 | 2,122,687,678,244 | 100% | ||

| elizacheng | 0 | 91,994,683,810 | 50% | ||

| aaronli | 0 | 233,330,223,556 | 50% | ||

| mrpointp | 0 | 261,955,130,072 | 50% | ||

| cn-reader | 0 | 16,754,468,818 | 50% | ||

| yellowbird | 0 | 625,059,029 | 100% | ||

| mawit07 | 0 | 10,731,507,628 | 25% | ||

| jychbetter | 0 | 386,959,826,495 | 50% | ||

| winniex | 0 | 235,228,792,950 | 50% | ||

| windowglass | 0 | 286,496,996,452 | 50% | ||

| halleyleow | 0 | 6,750,730,034 | 90% | ||

| angelina6688 | 0 | 5,012,584,935 | 50% | ||

| auleo | 0 | 32,762,479,400 | 50% | ||

| cheva | 0 | 187,768,647,119 | 50% | ||

| cherryng | 0 | 32,250,983,662 | 50% | ||

| nostalgic1212 | 0 | 310,309,909,641 | 50% | ||

| aellly | 0 | 132,196,424,640 | 50% | ||

| ryenneleow | 0 | 5,951,906,835 | 80% | ||

| abdullahj | 0 | 515,055,392 | 50% | ||

| wwstreet | 0 | 25,791,456,616 | 100% | ||

| tanlikming | 0 | 20,326,466,302 | 100% | ||

| archisteem | 0 | 1,274,556,179 | 7.5% | ||

| graceli | 0 | 19,543,235,754 | 50% | ||

| julian2013 | 0 | 38,165,924,309 | 50% | ||

| bitalk-cc | 0 | 203,338,491,910 | 50% | ||

| cherryzz | 0 | 32,819,932,127 | 50% | ||

| bsfmalaysia | 0 | 5,528,811,043 | 50% | ||

| ladyyunajay | 0 | 2,298,786,908 | 45% | ||

| dailyke20 | 0 | 1,279,774,344 | 50% | ||

| hybrintelligence | 0 | 1,144,176,814 | 50% | ||

| ying82 | 0 | 80,316,399,412 | 50% | ||

| lovequeen | 0 | 187,108,707,084 | 50% | ||

| logicforce | 0 | 1,413,430,540 | 25% | ||

| evahe | 0 | 163,783,424,636 | 50% | ||

| badstrategylive | 0 | 770,480,653 | 50% | ||

| hivevote | 0 | 19,137,147,826 | 50% | ||

| philipmak | 0 | 691,460,532 | 25% | ||

| emma-emma | 0 | 21,949,005,852 | 50% | ||

| pancovideo | 0 | 750,394,802 | 50% | ||

| morogambler | 0 | 836,924,317 | 50% | ||

| ricestrela | 0 | 988,138,421 | 50% | ||

| nicklyons | 0 | 806,362,598 | 50% | ||

| ericaliu | 0 | 18,501,470,768 | 50% | ||

| dengyanping888 | 0 | 65,259,902,410 | 50% | ||

| lovelingling | 0 | 113,872,841,320 | 50% | ||

| mao317 | 0 | 6,233,558,855 | 100% | ||

| everlandd | 0 | 12,597,044,655 | 50% | ||

| zhangyan-123 | 0 | 117,020,513,988 | 50% | ||

| alpha-omega | 0 | 55,142,092,335 | 50% | ||

| circlebubble | 0 | 11,046,794,660 | 50% | ||

| diochen | 0 | 12,880,639,929 | 50% | ||

| waivio.welcome | 0 | 706,115,536 | 1.38% | ||

| mdasein | 0 | 2,397,715,143 | 25% | ||

| kathyto | 0 | 32,669,917,376 | 50% | ||

| huolian | 0 | 20,364,398,664 | 50% | ||

| biaojie | 0 | 25,275,089,721 | 50% | ||

| the-lead | 0 | 477,412,282 | 25% | ||

| lifang123 | 0 | 5,251,940,697 | 50% | ||

| richardlin | 0 | 35,909,424,137 | 50% | ||

| weiliyu | 0 | 15,663,121,830 | 50% |

hiveblocks

hiveblocks