在Memo使用AES加密的过程中,除了使用到shared_secret外,还涉及到两个数值:分别是`nonce`以及`check`。

(图源 :[pixabay](https://pixabay.com/))

# nonce & check

其中`nonce`是一个64位的随机数(8字节),在BM的一篇文章中曾有提及:

>The purpose of the 'nonce' field is to generate a unique encryption key for every transfer between two accounts. I it should be a random number.

而`check`则是密钥的32位(4字节)摘要,保证字节串中内容没被破坏掉(其实我觉得并没有啥用,因为它只对加密密钥检查,并没有检查加密后的信息)

这两个数值的具体作用我们就简单说到这里,之所以提到这两个数值,是因为这两个数值要和加密后的文本一起用base58编码打包进memo。

因为打包用的是字符串串接,所以我自作聪明地写了类似如下代码:

>`str_nonce = '%016x' % nonce`

>`str_check = '%08x' % check`

目的是把这两个转成字符串,然后串接到Memo包里。然而加密Memo是生成了,解密时却出现:

> assert check == checksum, "Checksum failure"

> AssertionError: Checksum failure

这充分说明我传入的数值不对嘛,可是问题出在哪里呢?我百思不得其解。

# 字节序 / Byte Order

其实稍微分析一下,这事就不难想明白。我不过是将数据打包进memo,然后再拆包出来,拆包的部分代码如下:

>`nonce = str(struct.unpack_from("<Q", unhexlify(raw[:16]))[0])`

>`raw = raw[16:]`

>`check = struct.unpack_from("<I", unhexlify(raw[:8]))[0]`'

注意到什么了没有?没错,就是字节序(Byte Order)的问题!什么叫做字节序呢?简单来讲就是:

>大于一个字节类型的数据在内存中的存放或者传递时顺序。

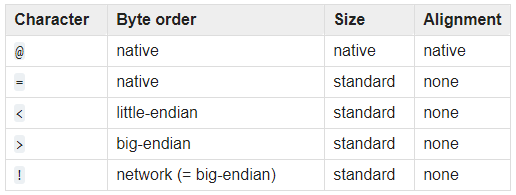

而Python struct 中字节序的标识如下:

>

由此不难看出,我们解包时是按little-endian(<)解包`nonce`和`check`的,亦即:

>低位字节排放在内存的低地址端,高位字节排放在内存的高地址端。

再对比一下如下代码:

>`a = 0x0123456789abcdef`

>`str_1 = '%016x' % a`

>`str_2 = hexlify(struct.pack("<Q", a)).decode()`

>`str_3 = hexlify(struct.pack(">Q", a)).decode()`

>`print(str_1, str_2, str_3)`

输出为:`0123456789abcdef` `efcdab8967452301` `0123456789abcdef`

由此可见,直接用`%016x`生成的字符串是把原数据按Big endian放置的!

# 解决方法

知道了引起错误的原因是因为字节序问题,那么解决起来就好办多了,使用如下代码生成字符串即可:

>`str_nonce = hexlify(struct.pack("<Q", int(nonce))).decode()`

>`str_check = hexlify(struct.pack("<I", int(check))).decode()`

你可能会问,既然是字节序问题,那么我们解包的程序也按着相同的字节序处理不也一样嘛?道理是这个道理,不过问题是无论打包还是解包都单单自己要用,你可能要给别人发送memo,也可能接收别人的memo,所以***必须按着相同的规范和标准来哦***。

# 相关链接

* [字节序](https://baike.baidu.com/item/%E5%AD%97%E8%8A%82%E5%BA%8F)

* [Little-Endian](https://baike.baidu.com/item/Little-Endian/4118225)

* [struct — Interpret bytes as packed binary data](https://docs.python.org/3.8/library/struct.html)| author | oflyhigh |

|---|---|

| permlink | little-endian-big-endian |

| category | hive-105017 |

| json_metadata | {"tags":["cn","cutehive","cn-programming","memo","byteorder"],"image":["https://cdn.pixabay.com/photo/2017/09/03/09/05/binary-code-2709626_960_720.jpg","https://images.hive.blog/DQmboAJMEgE1YFu54a2uxeD54J6gvQLiBjxkR9XaM6Wb1WJ/image.png"],"links":["https://pixabay.com/","https://baike.baidu.com/item/%E5%AD%97%E8%8A%82%E5%BA%8F","https://baike.baidu.com/item/Little-Endian/4118225","https://docs.python.org/3.8/library/struct.html"],"app":"hiveblog/0.1","format":"markdown"} |

| created | 2020-05-07 03:47:00 |

| last_update | 2020-05-07 03:47:00 |

| depth | 0 |

| children | 0 |

| last_payout | 2020-05-14 03:47:00 |

| cashout_time | 1969-12-31 23:59:59 |

| total_payout_value | 31.596 HBD |

| curator_payout_value | 28.215 HBD |

| pending_payout_value | 0.000 HBD |

| promoted | 0.000 HBD |

| body_length | 2,151 |

| author_reputation | 6,413,985,520,840,470 |

| root_title | "每天进步一点点:字节序的问题 (little-endian/big-endian)" |

| beneficiaries | [] |

| max_accepted_payout | 1,000,000.000 HBD |

| percent_hbd | 10,000 |

| post_id | 97,231,911 |

| net_rshares | 96,919,623,578,398 |

| author_curate_reward | "" |

| voter | weight | wgt% | rshares | pct | time |

|---|---|---|---|---|---|

| abit | 0 | 25,785,974,928,937 | 100% | ||

| adm | 0 | 27,747,317,837,902 | 100% | ||

| gerber | 0 | 307,034,302,197 | 4.4% | ||

| daan | 0 | 77,138,345,554 | 8% | ||

| fundurian | 0 | 138,227,093,426 | 95% | ||

| deanliu | 0 | 1,823,113,330,618 | 100% | ||

| exyle | 0 | 1,120,176,661,820 | 12% | ||

| joythewanderer | 0 | 386,042,986,822 | 50% | ||

| lemooljiang | 0 | 469,208,089,121 | 88% | ||

| ace108 | 0 | 588,818,454,782 | 25% | ||

| laoyao | 0 | 46,917,969,939 | 100% | ||

| somebody | 0 | 11,917,498,512 | 100% | ||

| skysunny | 0 | 99,405,402 | 88% | ||

| midnightoil | 0 | 164,635,105,125 | 100% | ||

| xiaohui | 0 | 931,589,195,590 | 100% | ||

| oflyhigh | 0 | 4,696,336,322,346 | 100% | ||

| yulan | 0 | 16,734,987,097 | 100% | ||

| rivalhw | 0 | 1,883,703,127,969 | 100% | ||

| nextgen622 | 0 | 1,601,381,946,791 | 100% | ||

| helene | 0 | 1,225,569,433,559 | 100% | ||

| ffcrossculture | 0 | 403,271,547,168 | 100% | ||

| themanualbot | 0 | 50,742,585,830 | 10% | ||

| ethansteem | 0 | 395,620,114,027 | 100% | ||

| sweetsssj | 0 | 14,269,883,879,341 | 35% | ||

| netaterra | 0 | 342,641,869,150 | 16% | ||

| someguy123 | 0 | 39,853,620,600 | 4.4% | ||

| funnyman | 0 | 4,393,777,991 | 20% | ||

| lexikon082 | 0 | 1,146,878,443 | 100% | ||

| slider2990 | 0 | 10,563,004,498 | 50% | ||

| dapeng | 0 | 32,602,681,728 | 100% | ||

| devilwsy | 0 | 3,289,044,951 | 100% | ||

| janiceting | 0 | 3,302,730,640 | 100% | ||

| timool | 0 | 834,922,197 | 88% | ||

| lucknie | 0 | 14,437,475,470 | 88% | ||

| dumping | 0 | 1,522,270,790 | 88% | ||

| jinghua | 0 | 0 | 88% | ||

| blackbunny | 0 | 73,644,992,353 | 100% | ||

| elizacheng | 0 | 16,223,874,432 | 9% | ||

| bxt | 0 | 252,515,723,683 | 100% | ||

| lingfei | 0 | 82,548,314,021 | 100% | ||

| justinashby | 0 | 42,812,993,557 | 100% | ||

| yyyy | 0 | 463,625,853 | 100% | ||

| kingsmind | 0 | 48,411,522,470 | 100% | ||

| teachblogger | 0 | 2,117,427,082 | 50% | ||

| htliao | 0 | 37,886,404,898 | 20% | ||

| dune69 | 0 | 12,691,801,371 | 8.4% | ||

| curly-q | 0 | 2,239,811,031 | 100% | ||

| mys | 0 | 881,154,694 | 0.28% | ||

| rycharde | 0 | 1,050,239,988 | 10% | ||

| exec | 0 | 247,474,249,045 | 100% | ||

| eval | 0 | 858,028,916 | 100% | ||

| ew-and-patterns | 0 | 205,152,640,426 | 10% | ||

| d-pend | 0 | 60,997,885,038 | 2.2% | ||

| susanli3769 | 0 | 146,289,761,964 | 100% | ||

| violetmed | 0 | 6,224,790,214 | 1.1% | ||

| otom | 0 | 16,509,598,050 | 20% | ||

| travelgirl | 0 | 114,154,859,152 | 40% | ||

| shitsignals | 0 | 2,977,963,732 | 2.2% | ||

| ralph-rennoldson | 0 | 694,675,745 | 1.6% | ||

| catwomanteresa | 0 | 123,061,543,742 | 50% | ||

| hannahwu | 0 | 47,134,703,361 | 100% | ||

| oldman28 | 0 | 33,530,733,866 | 48% | ||

| liangfengyouren | 0 | 3,195,741,988 | 50% | ||

| stevenmosoes | 0 | 2,669,085,979 | 50% | ||

| cn-reader | 0 | 13,033,930,154 | 50% | ||

| tvb | 0 | 19,922,406,207 | 30% | ||

| skenan | 0 | 8,454,540,340 | 50% | ||

| kimzwarch | 0 | 7,402,962,021 | 4% | ||

| bboyady | 0 | 602,753,503 | 2% | ||

| accelerator | 0 | 83,859,221,548 | 8.8% | ||

| chinchilla | 0 | 242,418,040,566 | 100% | ||

| chenlocus | 0 | 8,437,181,955 | 100% | ||

| davidke20 | 0 | 9,912,593,934 | 4% | ||

| roleerob | 0 | 3,583,477,476 | 0.79% | ||

| deathwing | 0 | 1,981,219,121 | 4.4% | ||

| xiaoshancun | 0 | 3,491,595,481 | 100% | ||

| victory622 | 0 | 167,240,881,112 | 100% | ||

| metten | 0 | 8,014,369,134 | 88% | ||

| pataty69 | 0 | 1,500,931,430 | 2.2% | ||

| caladan | 0 | 17,334,849,232 | 10.2% | ||

| blockbrothers | 0 | 13,596,152,308 | 6% | ||

| cn-book | 0 | 890,899,655 | 88% | ||

| emrebeyler | 0 | 76,192,720,718 | 4.4% | ||

| cn-movie | 0 | 85,158,280 | 88% | ||

| etherpunk | 0 | 1,391,968,662 | 25% | ||

| itchyfeetdonica | 0 | 124,186,696,909 | 50% | ||

| vivia | 0 | 2,565,573,817 | 88% | ||

| girolamomarotta | 0 | 31,263,981,011 | 50% | ||

| yikloongye | 0 | 0 | 4% | ||

| johnhooi | 0 | 0 | 4% | ||

| nealmcspadden | 0 | 75,129,068,465 | 4.4% | ||

| maiyude | 0 | 1,282,880,994 | 50% | ||

| suhunter | 0 | 957,285,423 | 50% | ||

| xiaoli | 0 | 233,800,191 | 88% | ||

| yumisee | 0 | 3,201,811 | 4% | ||

| joeliew | 0 | 92,675,861 | 4% | ||

| hkit98 | 0 | 0 | 4% | ||

| elvinmas001 | 0 | 0 | 4% | ||

| watersoo | 0 | 84,751,709 | 4% | ||

| vamos-amigo | 0 | 112,854,032 | 4% | ||

| cadawg | 0 | 8,604,290,491 | 3.08% | ||

| sudefteri | 0 | 15,562,145,421 | 100% | ||

| happy-soul | 0 | 71,586,791,071 | 10% | ||

| iipoh06 | 0 | 0 | 4% | ||

| annabellenoelle | 0 | 0 | 4% | ||

| pizzapai | 0 | 1,910,061,805 | 100% | ||

| yethui | 0 | 0 | 4% | ||

| riczlook | 0 | 0 | 4% | ||

| ethanlee | 0 | 5,666,037,980 | 100% | ||

| andrewnoel | 0 | 0 | 4% | ||

| fishbb | 0 | 772,557,095 | 25% | ||

| fredo77200 | 0 | 3,665,154,696 | 100% | ||

| bestboom | 0 | 32,697,554,771 | 4.4% | ||

| freddio | 0 | 48,421,011,739 | 15% | ||

| ryenneleow | 0 | 4,847,349,045 | 90% | ||

| therising | 0 | 2,907,843,512,312 | 20% | ||

| angelinafx | 0 | 3,327,363,397 | 6% | ||

| payroll | 0 | 3,319,664,335,884 | 10% | ||

| thebot | 0 | 152,487,981,421 | 100% | ||

| competeapp | 0 | 886,293,855,897 | 100% | ||

| hmayak | 0 | 22,948,911,375 | 100% | ||

| archisteem | 0 | 2,490,760,680 | 7.5% | ||

| cn-malaysia | 0 | 1,840,642,969 | 4% | ||

| gorans | 0 | 5,043,024,328 | 100% | ||

| kahvesizlik | 0 | 1,237,814,963 | 100% | ||

| moneybaby | 0 | 891,340,351 | 2.5% | ||

| suonghuynh | 0 | 840,662,895,104 | 6% | ||

| abcallen | 0 | 15,478,087,472 | 80% | ||

| gallerani | 0 | 5,197,669,588 | 4.4% | ||

| rachman-jr25 | 0 | 708,160,573 | 100% | ||

| yestermorrow | 0 | 8,902,823,877 | 31% | ||

| dalz | 0 | 21,938,860,192 | 10% | ||

| sunai | 0 | 3,729,321,149 | 100% | ||

| smartvote | 0 | 360,899,193,989 | 6% | ||

| blues-wclouds | 0 | 1,752,244,175 | 100% | ||

| julian2013 | 0 | 11,361,652,591 | 5% | ||

| dlike | 0 | 52,863,375,305 | 4.4% | ||

| triptolemus | 0 | 5,901,985,370 | 4.4% | ||

| voxmortis | 0 | 57,580,277,024 | 20% | ||

| coinmarketcal | 0 | 6,479,806,977 | 22% | ||

| bobby.madagascar | 0 | 1,507,282,935 | 1.1% | ||

| jamzmie | 0 | 1,287,935,554 | 15% | ||

| sasaadrian | 0 | 2,034,670,183 | 20% | ||

| pollygonewild | 0 | 0 | 4% | ||

| foodblogresteem | 0 | 0 | 4% | ||

| followjohngalt | 0 | 21,237,947,669 | 9.6% | ||

| new-steemit | 0 | 7,047,733,008 | 10% | ||

| starrouge | 0 | 995,249,860 | 50% | ||

| rasalom | 0 | 15,211,247,660 | 100% | ||

| zerofive | 0 | 822,537,605 | 50% | ||

| tagalong | 0 | 2,738,809,090 | 100% | ||

| determine | 0 | 5,191,112,015 | 4.4% | ||

| cnstm | 0 | 412,290,155,677 | 100% | ||

| permaculturedude | 0 | 831,731,495 | 2.2% | ||

| likuang007 | 0 | 34,066,112,878 | 100% | ||

| jacoblai | 0 | 0 | 4% | ||

| lianjingmedia | 0 | 909,344,767 | 100% | ||

| bobdavids | 0 | 0 | 4% | ||

| chocolatelover | 0 | 4,000,334,788 | 40% | ||

| hungryharish | 0 | 6,291,159,223 | 100% | ||

| elektroyazilim | 0 | 625,247,848 | 60% | ||

| kryptogames | 0 | 88,622,605,155 | 20% | ||

| lovelemon | 0 | 44,215,384,375 | 100% | ||

| hungryanu | 0 | 2,852,212,922 | 50% | ||

| steemindian | 0 | 22,247,930,751 | 100% | ||

| map10k | 0 | 17,017,199,112 | 12% | ||

| vxc | 0 | 670,118,722 | 6.6% | ||

| triplea.bot | 0 | 3,683,142,950 | 12% | ||

| hyborian-strain | 0 | 1,778,496,872 | 30% | ||

| freddio.sport | 0 | 5,502,859,274 | 15% | ||

| asteroids | 0 | 16,631,512,441 | 4.4% | ||

| mapxv | 0 | 17,247,649,649 | 11% | ||

| leo.syndication | 0 | 1,016,765,788 | 4.4% | ||

| one.life | 0 | 4,044,081,384 | 4.39% | ||

| maxuvd | 0 | 16,586,637,677 | 4.4% | ||

| maxuve | 0 | 29,996,667,883 | 8.8% | ||

| dw-g8m8k1042298 | 0 | 0 | 4% | ||

| teresa.yaiyai | 0 | 8,142,979,703 | 100% | ||

| downvoteme | 0 | -30,952,246,606 | -50% | ||

| dw-fn0uh101562u | 0 | 0 | 4% | ||

| therealyme | 0 | 594,698,306 | 9.6% | ||

| abdulwajid1978 | 0 | 551,089,193 | 100% | ||

| gerbo | 0 | 5,137,819 | 4.4% | ||

| starnote | 0 | 165,594,286 | 88% | ||

| simply2koool | 0 | 10,621,250,206 | 25% | ||

| ribary | 0 | 108,487,594,140 | 6% | ||

| moochain.net | 0 | 166,974,367 | 88% | ||

| earthworld | 0 | 2,398,432,485 | 35% | ||

| sujaytechnicals | 0 | 247,527,373 | 100% | ||

| steemcityrewards | 0 | 13,970,478,111 | 4.4% | ||

| dpend.active | 0 | 7,036,345,999 | 4.4% | ||

| lovequeen | 0 | 12,008,798,685 | 100% |

hiveblocks

hiveblocks